Hintergründe: Die GPU

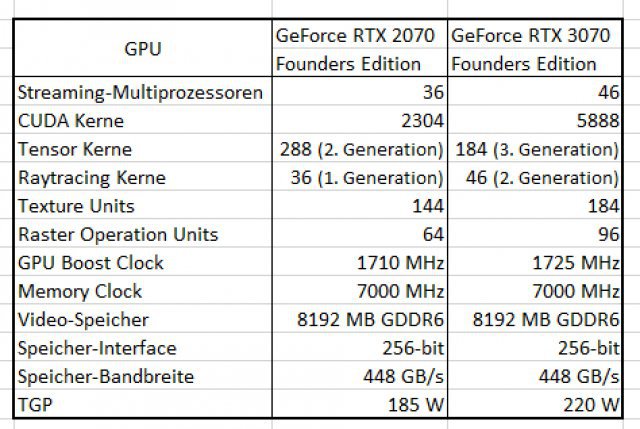

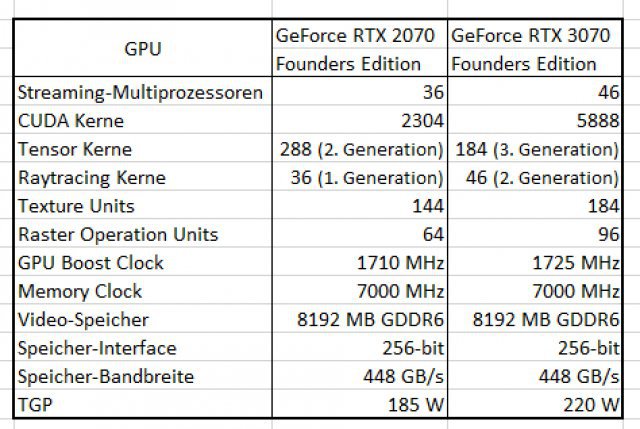

Die GPU wurde im 8-Nanometer-Verfahren (Turing: 12 nm) produziert und umfasst 17,4 Mrd. Transistoren (RTX 3080: 28 Mrd. Transistoren). Sie besteht aus drei Bereichen: der Streaming-Prozessor (CUDA) für die "normalen" und häufig anfallenden Rechenoperationen im Grafiksektor, die RT-Kerne für die Hardware-beschleunigte Berechnung von Raytracing in Echtzeit sowie die Tensor-Kerne, die vor allem bei KI-Anwendungen auf Basis von neuronalen Netzwerken zum Einsatz kommen sollen. Nvidias "Deep Learning Super Sampling" (DLSS) nutzt z.B. diese Tensor-Kerne: Das ist eine wirklich beeindruckende, KI-gestützte Methode zur Hochskalierung von Grafiken mit einem beträchtlichen Zugewinn bei der Bildwiederholrate ohne große optische Abstriche. Stellenweise schafft es DLSS sogar, die Schärfe und die Qualität der Grafik paradoxerweise zu erhöhen, obwohl die Grafik ja im eigentlichen Sinne hochskaliert und mit KI nachgeschärft wird.

Nvidia will im Vergleich zu Turing die Anzahl der normalen Berechnungen (programmierbare Shader) um den Faktor Zwei gesteigert haben, gerade im Bereich der 32-Bit-Fließkommaoperationen, die vor allem beim Raytracing-Rendering und bei aufwändigen Shadern erforderlich sind (RTX 2070: 7,9 Shader TFLOPS; RTX 3070: 20,3 Shader TFLOPS). Die zweite Generation der RT-Kerne sollen die mehrstufigen Raytracing-Operationen 1,7 Mal so schnell wie beim Vorgänger berechnen können (RTX 2070: 23,8 RT TFLOPS; RTX 3070: 39,7 RT TFLOPS). Die dritte Generation des Tensor-Cores verspricht ebenfalls eine Leistungssteigerung um mehr als das Zweifache, da automatisch weniger wichtiger Elemente entfernt und "Sparse Networks" schneller berechnet werden können (RTX 2070: 63,0 Tensor-TFLOPS; RTX 3070: 162,6 Shader Tensor-TFLOPS; bei "Sparse Networks").

RAM-Austattung, Anschlüsse und RTX I/O-Zukunft

Die RTX 3070 verfügt über drei Display-Port-Anschlüsse (1.4a) und einen HDMI-2.1-Ausgang. Auch AV1 Decode (AOMedia Video 1) wird unterstützt.

8 GB GDDR6-Grafikspeicher kommen zum Einsatz (Bandbreite: 256-bit; theoretische Übertragung: 448 GB pro Sekunde). In der RTX 3080 wurde der schnellere GDDR6X-Speicher verbaut (Bandbreite: 320-bit; theoretische Übertragung: 760 GB pro Sekunde). Auch wenn der Grafikspeicher in unseren Testläufen ausreichte, kann es sein, dass 8 GB für 4K-Gaming mit maximalen Qualitätseinstellungen (z.B. bei Texturen) in Zukunft etwas knapp werden könnte.

Es kann davon ausgegangen werden, dass der Videospeicherbedarf in den nächsten Jahren steigen wird. Zumal mit RTX I/O und anderen Technologien auch das Laden bzw. Nachladen von neuen Daten enorm beschleunigt werden kann - und deswegen es viel schneller möglich sein wird, neue Daten in den Grafikspeicher abzulegen. Für diejenigen, die eine NVMe-SSD mit einer RTX-3000er-Karte nutzen, dürfte RTX I/O auch dafür sorgen, dass Videospeicher kein stark limitierender Faktor für die Leistung sein wird - allerdings muss zunächst die Software-Schnittstelle (DirectStorage) die entsprechenden Technologien unterstützen und das kann noch bis zu ein Jahr dauern (

Quelle).

Temperatur, Lautstärke und Strom/Watt

Die Grafikkarte erwärmt sich bei maximaler Auslastung stark und wurde im Testverlauf bis zu 72 °C warm. Die RTX 2080 Ti und RTX 3080 wurden etwas heißer. Die zwei (oben) auf der Founders Edition platzierten Lüfter waren bei Intensiv-Betrieb hörbar. Im Idle-Bereich, also z.B. im Desktop- oder Office-Betrieb, war die RTX 3070 völlig unauffällig und leise. Der maximale Gesamtstromverbrauch (TGP) bzw. die Leistungsaufnahme der Grafikkarte liegt bei 220 Watt, weswegen ein 650 Watt Netzteil empfohlen wird. Laut Angaben von Nvidia soll die Ampere-Generation im Vergleich zu Turing effizienter bei gleicher Performance arbeiten (Faktor 1,9; höhere fps-Rate pro Watt). Für die Stromversorgung an der Seite der Grafikkarte ist ein neuer 12-poliger Anschuss vorgesehen. In der Founders Edition liegt ein Adapter bei, der einen PCIe 8-poligen Stecker auf den neuen 12-poligen Anschluss bringt. Laut

Igor's Lab ist die RTX 3070 auch effizienter, leise und "relativ kühl" im Vergleich zu den bisherigen Modellen.

Die RTX 3070 in der Founders Edition von Nvidia im Vordergrund.

Nvidia Reflex, Studio und Broadcast

Zu den Neuerungen, die mit der 3000er-Reihe eingeführt werden, gehört ebenfalls Nvidia Reflex zur Senkung der Systemlatenz in kompetitiven eSports-Titeln, sofern die Spiele den Low-Latency Mode nutzen (Apex Legends, Call of Duty: Warzone, Fortnite und Valorant). Laut Hersteller wird die Latenz um bis zu 50 Prozent reduziert, dieser Aspekt soll an dieser Stelle nur erwähnt werden. Getestet haben wir Nvidia Reflex nicht, auch mangels vergleichbaren Messmethoden. Des Weiteren verspricht die RTX-30-Serie eine Zeitersparnis bei Multi-App-Workflows, 8K-HDR-Videobearbeitung und der Arbeit mit großen 3D-Modellen - sowie bei der Anwendung von Raytracing. Live-Streamer sollen von Nvidia Broadcast profitieren, z.B. von der automatischen Entfernung von Störgeräuschen, Hintergrundeffekte und einen virtuellen Kameramann. Nvidia Broadcast läuft übrigens auf jeder RTX-GPU.